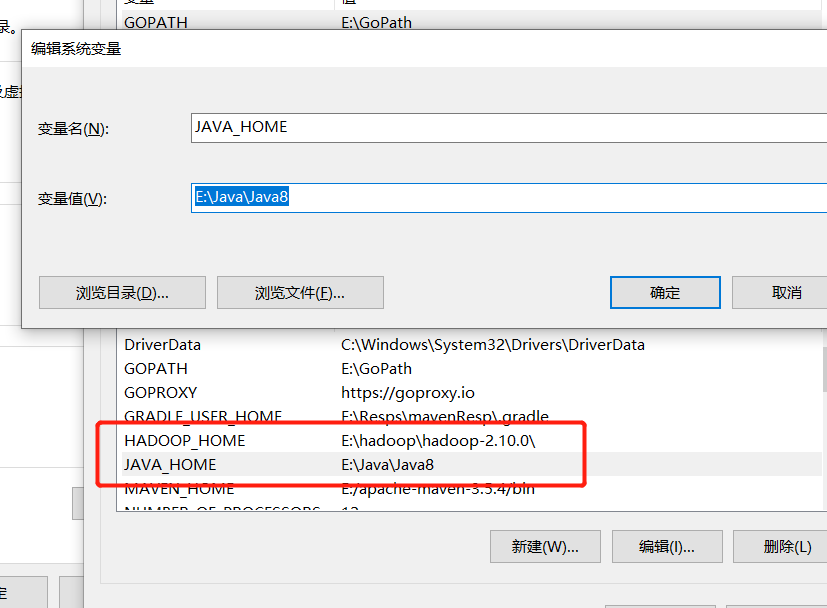

1. 配置JAVA_HOME环境和Hadoop环境:

2. 配置bin

3. 进入Hadoop中/etc/hadoop下

配置hdfs-site.xml增加:

<property>

<!-- 单节点,所以配置成1 -->

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- 指定Hadoop辅助名称节点主机配置,即:2NN配置 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>localhost:50090</value>

</property>

<!-- 配置前台访问页面 -->

<property>

<name>dfs.namenode.http.address</name>

<value>slave1:50070</value>

</property>

配置core-site.xml文件:

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:9820</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/I:/BigData</value>

</property>

4. 配置hadoop-env.cmd 的JAVA_HOME环境变量:

set JAVA_HOME=E:\Java\Java8

5. 运行命令: hdfs namenode -format 运行没报错即可

————————-报错—————————————————

1. 运行 hdfs namenode -format 报错,异常:

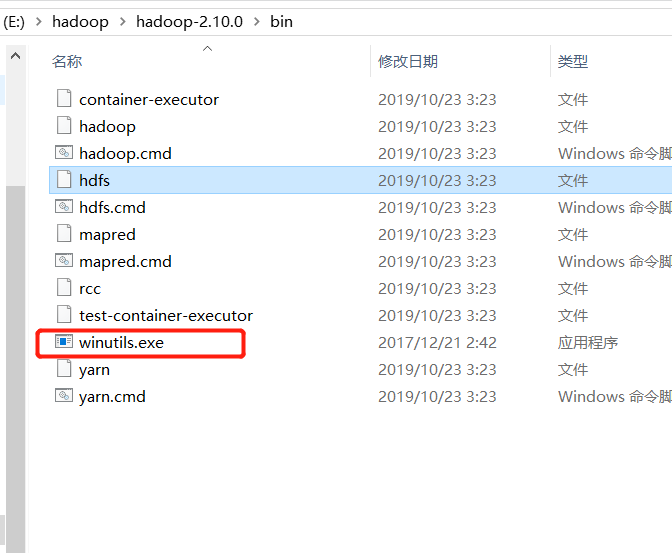

格式化失败,将此文件放到bin下

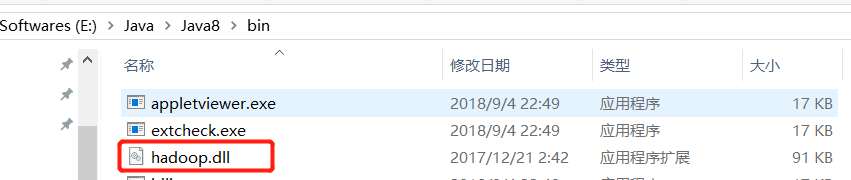

2. 报错

org.apache.hadoop.io.nativeio.NativeIO$Windows.access0(Ljava/lang/String;I)Z

将hadoop.dll放到java的bin目录下即可

转自:https://www.cnblogs.com/mrsans/articles/12452484.html