开发环境介绍

操作系统版本:Ubuntu16.04 LTS 64-bit,编译TVM的host、target版本;

目标器件为Firefly-RK3399,采用双核Cortex-A72和四核Cortex-A53的大小核架构。

MXNet版本: v1.2.1

LLVM版本: v6.0

TVM版本: v0.4.0

交叉编译工具链版本:gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux

TVM编译、安装和测试顺序

TVM按照以下顺序来进行编译、安装:

编译MXNet(host版本,暂时以GPU模式安装)

安装LLVM

编译TVM(host版本)

交叉编译环境搭建

编译TVM runtime(target版本)

编译MXNet(host版本)

因为我们暂时测试的TVM前端模型是MXNet模型,所以进行编译模型之前要先安装host版本的MXNet。这里我们最简单的通过python-pip的方式进行安装。

更新python和pip

sudo apt-get update

sudo apt-get install -y wget python gcc

wget https://bootstrap.pypa.io/get-pip.py && sudo python get-pip.py

安装MXNet

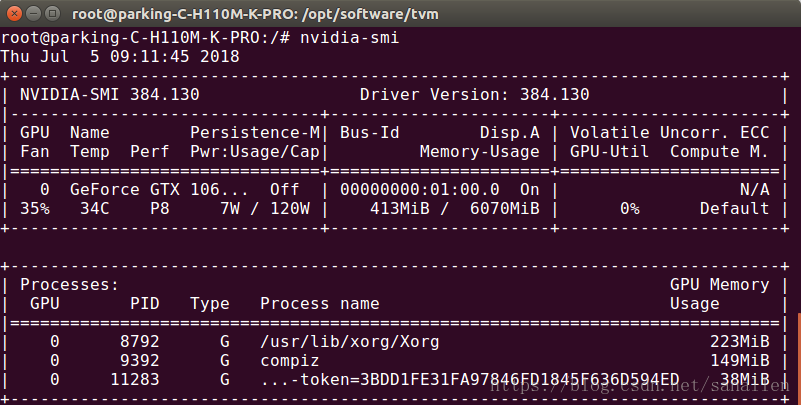

安裝GPU版本(主机采用Nvidia的GTX1060)的MXNet时,需要提前安装好Nvidia库来驱动GPU。主要包括CUDA9.0(安装教程)和cuDNN(安装教程)两部分。

运行下面命令即可查看CUDA和cuDNN是否已经安装,以及对应版本号。

nvidia-smi

nvcc –version

安装对应CUDA版本的MXNet

pip install mxnet-cu90

# 可选项,安装graphviz,为使用mxnet.viz包进行图形可视化所需。

apt-get install graphviz

pip install graphviz

# 可选项,安装Intel MKL

pip install mxnet-cu90mkl

验证安装是否成功安装

python

# 进入python运行空间,然后输入以下python代码进行验证

>>> import mxnet as mx

>>> a = mx.nd.ones((2, 3)), mx.gpu())

>>> b = a * 2 + 1

>>> b.asnumpy()

array([[ 3., 3., 3.],

[ 3., 3., 3.]], dtype=float32)

# 如果上述代码执行正确则表示MXNet host版本已经正确安装

>>> exit()

安装LLVM

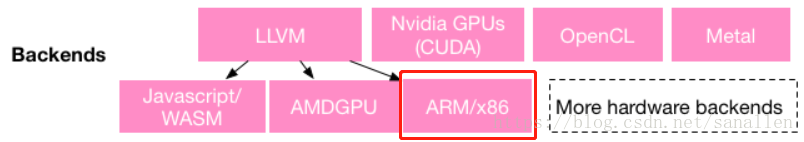

如下图所示TVM对于ARM后端的支持是基于LLVM编译器实现的,TVM对于的LLVM版本的最低要求为4.0,最高版本不能超过6.0。本次安装LLVM版本6.0。

添加LLVM相关的apt-get源

第一步,首先编辑 /etc/apt/sources.list,加入以下源:

deb http://apt.llvm.org/xenial/ llvm-toolchain-xenial-6.0 main

deb-src http://apt.llvm.org/xenial/ llvm-toolchain-xenial-6.0 main

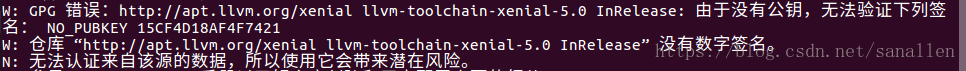

添加源后务必运行apt-get update,如果有错误提示,先运行第二步,然后apt-get update)

第二步,安装前必须取得相关证书

wget -O – http://llvm.org/apt/llvm-snapshot.gpg.key|sudo apt-key add –

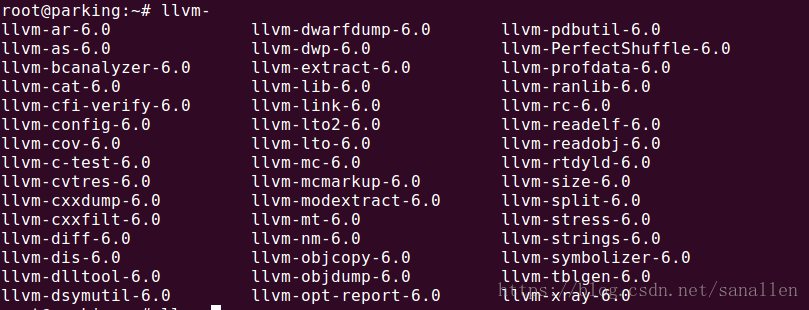

1安装llvm

apt-get install clang-6.0 lldb-6.0

1显示如下即安装成功

上面的脚本只适用于Ubuntu16.04添加LLVM 6.0,如果你使用的是其他的操作系统和LLVM版本可以参考这里。

编译TVM(host版本)

安装cmake

由于TVM 0.4.0版本首次采用cmake作为编译配置工具,需要安装cmake。

cd /opt/software/

wget https://cmake.org/files/v3.11/cmake-3.11.0-rc2-Linux-x86_64.tar.gz

tar zxvf cmake-3.11.0-rc2-Linux-x86_64.tar.gz

ln -sf /opt/software/cmake-3.11.0-rc2-Linux-x86_64/bin/* /usr/bin/

下载TVM

# git命令中选项recursive表示要将项目全部文件都下载,包括子模块。

git clone –recursive https://github.com/dmlc/tvm/

apt-get update

apt-get install -y python python-dev python-setuptools gcc libtinfo-dev zlib1g-dev

配置LLVM选项

在运行cmake-gui命令之前,修改tvm/CMakeLists.txt内容

# 显示执行构建过程中详细的信息,如编译工具选择,有助于区分系统编译工具和交叉编译工具

set(CMAKE_VERBOSE_MAKEFILE ON)

# llvm-config路径为/usr/bin/llvm-config-6.0

tvm_option(USE_LLVM “Build with LLVM, can be set to specific llvm-config path” /usr/bin/llvm-config-6.0)

修改tvm/cmake/config.cmake

# 文件默认为set(USE_LLVM OFF)

set(USE_LLVM /usr/bin/llvm-config-6.0)

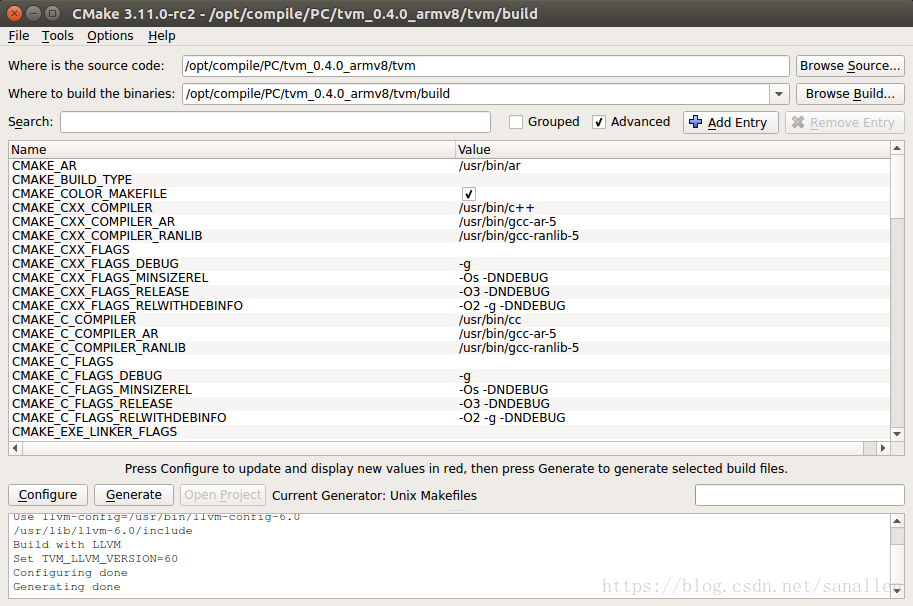

编译TVM

完成上述修改后,执行如下命令进行编译选项配置:

cd tvm

mkdir build

cd tvm/build

cmake-gui

make -j4

如果编译正常完成之后,会在tvm的lib目录下面生成一些库文件。

libnnvm_compiler.so

libtvm_runtime.so

libtvm.so

libtvm_topi.so

设置PYTHONPATH环境变量

在安装之前先在/etc/bash.bashrc中设置PYTHONPATH环境变量

export PYTHONPATH=/opt/compile/BoxV3/tvm_host/tvm/python:/opt/compile/BoxV3/tvm_host/tvm/topi/python:/opt/compile/BoxV3/tvm_host/tvm/nnvm/python:${PYTHONPATH}

重启命令行以重新加载PYTHONPATH

若不设置PYTHONPATH环境变量,每次修改TVM的python源码均需要通过以下命令更新源码:

cd tvm

cd python; python setup.py install; cd ..

cd topi/python; python setup.py install; cd ../..

cd nnvm/python; python setup.py install; cd ../..

修改TVM Python源代码

在安装Python包之前为了交叉编译模型需要修改TVM Python源代码

针对ARM编译器选项和芯片型号修改

armv7与armv8交叉编译采用不同架构的交叉编译工具链,arv8自带neon寄存器支持,不需要在源码中添加。

tvm/python/tvm/target.py

针对armv8目标器件进行修改:

def rasp(options=None):

“””Returns a rasp target.

Parameters

———-

options : str or list of str

Additional options

“””

opts = [“-device=rasp”,

“-mtriple=aarch64-linux-gnu”,

“-mcpu=cortex-a57”]

opts = _merge_opts(opts, options)

return _api_internal._TargetCreate(“llvm”, *opts)

针对armv7目标器件进行修改:

def rasp(options=None):

“””Returns a rasp target.

Parameters

———-

options : list of str

Additional options

“””

opts = [“-device=rasp”,

“-mtriple=arm-linux-gnueabihf”,

“-mcpu=cortex-a7”,

“-mattr=+neon”]

opts = _merge_opts(opts, options)

return _api_internal._TargetCreate(“llvm”, opts)

以下修改仅展示对armv8目标器件的修改内容,armv7器件在相同文件对应位置进行修改,替换为armv7的交叉工具链即可。

tvm/python/tvm/contrib/cc.py

def create_shared(output,

objects,

options=None,

cc=”aarch64-linux-gnu-g++”):

def _linux_shared(output, objects, options, cc=”aarch64-linux-gnu-g++”):

tvm/src/codegen/build_module.cc

注意:在测试时build_module.cc在vscode中未打开时无法搜索关键字来进行修改。

Target rasp(const std::vector<std::string>& options) {

return CreateTarget(“llvm”, MergeOptions(options, {

“-device=rasp”,

“-mtriple=aarch64-linux-gnu”,

“-mcpu=cortex-a57”

}));

}

tvm/tests/python/unittest/test_codegen_arm.py

def test_popcount():

target = ‘llvm -target=aarch64-linux-gnu -mcpu=cortex-a57’

tvm/tutorials/nnvm_quick_start.py

if use_rasp:

target = “llvm -target=aarch64-linux-gnu -mcpu=cortex-a57”

tvm/nnvm/python/nnvm/frontend/mxnet.py

#第33行int改为long

def _parse_tshape(tshape):

“””Parse tshape in string.”””

return [long(x.strip()) for x in tshape.strip(‘()’).split(‘,’)]

编译安装TVM runtime(target版本)

交叉编译环境搭建

本文档目标器件为Firefly-RK3399(Cortex-A72+Cortex-A53,ARMv8架构),其他架构器件通常更换交叉编译链即可。

软件环境

交叉工具链:gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux

设置本地编译链和交叉编译链

在/etc/bash.bashrc中设置本地编译链和交叉编译链,重启命令行使设置生效

# Native Compiler

export AR_host=”ar”

export CC_host=”gcc”

export CXX_host=”g++”

export LINK_host=”g++”

#ARMv8 cross compiler

export ARCH=arm

export PATH=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin:$PATH

export CROSS_COMPILE=aarch64-linux-gnu-

export CC=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-gcc

export CXX=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-g++

export LD=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-ld

export AR=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-ar

export AS=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-as

export RANLIB=/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-ranlib

通过命令echo $CC查看aarch64-linux-gnu-gcc交叉编译工具是否生效

root@parking:/opt/compile/PC/tvm_0.4.0_armv8/tvm/build# echo $CC

/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/bin/aarch64-linux-gnu-gcc

重新复制一份TVM到另外的文件夹,保证不和TVM的host版本冲突,执行命令清除host编译工具生成的libtvm_runtime.so文件和cmake编译配置。

cd tvm

make clean

rm -r build/*

由于TVM runtime不需要LLVM,根据前面“配置LLVM选项”部分,屏蔽掉LLVM选项。

tvm/CMakeLists.txt

# llvm-config路径为/usr/bin/llvm-config-6.0

tvm_option(USE_LLVM “Build with LLVM, can be set to specific llvm-config path” OFF)

tvm/cmake/config.cmake

set(USE_LLVM OFF)

1

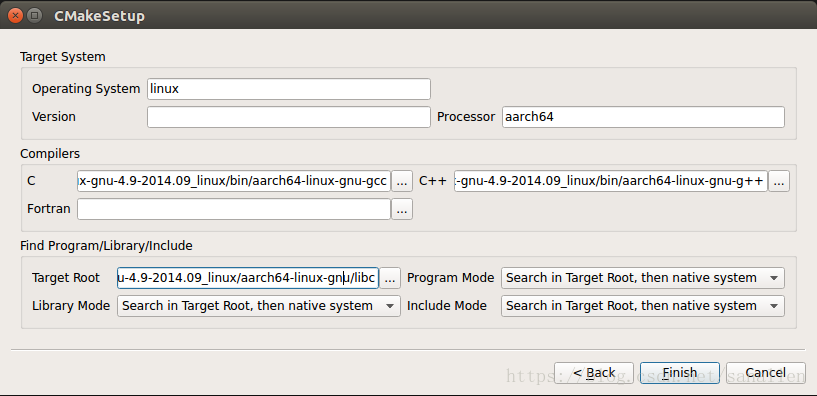

再次执行cmake-gui进行编译配置,选择”Specify options for cross-compiling”

其中,C/C++对应选择交叉编译工具链中的工具,Target Root目录如下:

/opt/toolchain/gcc-linaro-aarch64-linux-gnu-4.9-2014.09_linux/aarch64-linux-gnu/libc

make runtime

1

编译成功后build文件夹会生成libtvm_runtime.so

这里编译的tvm_runtime运行时库是最终需要部署到嵌入式设备中的,和TVM模型编译无关。

————————————————

版权声明:本文为CSDN博主「jack_201316888」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/u010451780/article/details/108801925